Le premier palier de dispatchings transport en france (1967-1988)

Cet ensemble d’articles présente la genèse des dispatchings de transport en France fin des années 1960, début des années 70.

Le contexte du projet

Le contexte d’exploitation du système électrique

Le développement important du réseau (en savoir plus), la mise en construction d’un parc de production de plus en plus centralisé, les exigences croissantes en matière de sûreté, de qualité et d’économie nécessitaient de mettre à disposition des dispatchings de plus en plus d’informations que l’on peut classer en deux catégories :

-

Les informations utilisées directement par les dispatcheurs en temps réel (télémesures, télésignalisations mais aussi informations obtenues par téléphone auprès du personnel des postes et centrales électriques),

-

Des informations supplémentaires utilisées pour élaborer

o les prévisions de consommation et les programmes de production (les traitements prévisionnels),

o les statistiques et la facturation des clients alimentés en THT/HT (les traitements a postériori).

Le premier type d’informations était acheminé depuis les postes et centrales par des équipements traditionnels basés sur l’analogique qui se sont révélés insuffisamment performants en terme de capacité, de précision et de disponibilité.

Quant au deuxième type, il faisait essentiellement l’objet d’une collecte manuelle puis d’un traitement sur machine à calculer qui n’était plus adapté au volume à traiter.

Le virage du numérique

Alors que la France des années soixante découvrait le rock’n’roll et le confort apporté par les débuts de l’électroménager grand public (en savoir plus), EDF, de façon novatrice a entamé le virage du numérique. En matière de système électrique, Il a porté sur deux volets, l’acheminement des informations au dispatching et les moyens de calculs, et s’est déroulé en 3 étapes :

-

1961 : décision d’approvisionner un calculateur pour le dispatching national.

Au début des années 60, les moyens de calcul dont disposait le dispatching national se réduisaient à une table à calcul à courant continu, utilisée pour des calculs de répartition de charge, les calculs de puissance de court-circuit et pour l’élaboration de plans optimaux de production (minimisation des pertes) (En savoir plus). Toutefois, le développement du réseau à 380 KV, l’arrivée de centrales de production à coûts marginaux (1) voisins ont rapidement rendu ces moyens de calcul très insuffisants (en savoir plus).

La mise sur le marché des premiers ordinateurs à vocation scientifique, la naissance en France de compétences sur le développement de logiciels « temps réel », (au sein notamment de la CAE) ainsi que l’évolution prévisible des capacités de rapatriement des informations depuis les postes et les centrales (cf infra le projet « infos codées ») ont conduit la direction d’EDF à approuver la commande d’un premier ordinateur le 25 octobre 1961. Ce fût un CAE 510 (2) , construit par la Compagnie Européenne d’Automatisme Electronique (CAE) sous licence américaine .Il était livré sans système d’exploitation avec quasiment comme seul outillage un compilateur Fortran ! Il a été installée en 1963 au Dispatching national pour y accueillir les modèles de calcul développés par la Direction des Etudes et Recherches d’EDF (DER).

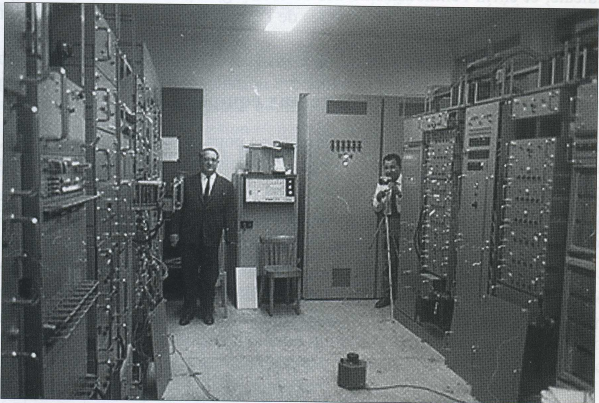

Un RW 530 grand frère du CAE 530.

on voit ici le pupitre et le lecteur perforateur de ruban papier et au deuxième plan les deux armoires du calculateur et celle du dérouleur de bande.

.

Il été remplacé ultérieurement par un CAE 90-80.

Il était prévu une montée en puissance de son utilisation en 3 étapes :

– Assurer la sécurité : implantation de calculs de réseaux (calculs de répartition, analyse de sécurité (impacts des déclenchements et calculs de courts-circuits (3)),

– Optimiser la production : implantation d’un modèle fournissant un plan de production des usines thermiques et hydrauliques pour le lendemain,

– Automatiser le réglage de la production : il s’agissait d’implanter l’algorithme du réglage secondaire fréquence-puissance (4) dans le calculateur

-

1962 : lancement du projet « informations codées » (en savoir plus) dont l’objectif était le suivant :

– Permettre le rapatriement en nombre au dispatching de télémesures avec une précision garantie de 1% et dans un délai de l’ordre de 10 secondes,

– Offrir à l’arrivée un format à la fois analogique pour présentation sur des enregistreurs (dont un certain nombre existaient) et numérique pour acquisition et traitements automatisés par un ordinateur.

L’offre de marché étant insuffisante, EDF a été conduite à faire réaliser des matériels sur la base de spécifications propres. Après la réalisation d’un prototype installé à Nantes en 1964, la fabrication en série a été lancée en 1965 et le déploiement s’est étalé de 1966 à 1971. La pièce maîtresse du dispositif était l’ERC (5) capable d’acquérir puis de transmettre toutes les 10 secondes 20 mesures ou 160 signalisations.

les ERC au poste des Tanneurs, site pilote, près de Nantes. les ERC au poste des Tanneurs, site pilote, près de Nantes. |

Les premiers à bénéficier de cette nouvelle technologie ont été les synoptiques qui outre les positions des organes de coupure pouvaient désormais afficher des valeurs de mesures sous forme de quartiles.

|

Il n’y a pas encore d’ordinateur, mais le tableau synoptique a pris de l’ampleur et les enregistreurs se sont multipliés. |

-

Décision d’équiper tous les dispatchings en SCADA

La mise à disposition aux dispatchings par le projet « infos codées » de mesures au format numérique a ouvert la voie à l’informatisation de tous les dispatchings. Décision fût donc prise vers 1964 d’équiper le dispatching national et les huit dispatchings régionaux d’un système informatique permettant l’acquisition des données en provenance du terrain, la présentation à l’opérateur de ces données, leur surveillance et la réalisation de post-traitements sur celles-ci ou des données introduites par ailleurs.

La réalisation

Les calculateurs retenus

Les calculateurs retenus ont été des calculateurs vendus par la CAE/CII de la série 90-XX. .

Dans son positionnement stratégique CAE s’était axé sur la réalisation de logiciels orientés temps réel à valeur ajoutée, Elle avait établi, à cet époque, que l’industrie des composants en France ne pouvait rivaliser avec celle des Etats-Unis, et que la construction de ses propres ordinateurs était trop risquée, alors que d’autre part, ses compétences en logiciels pointus était une opportunité à saisir, notamment avec le contrôle commande de la production thermique (classique et filière graphite gaz), les dispatchings et le domaine militaire. CAE/CII s’est donc associé avec Wooldridge dans un premier temps (RW530) puis avec SDS (Scientific Data System) dont elle a commercialisé la gamme C 900.

Les calculateurs finalement retenus furent des C 90-10 (SDS 910) qui ont été remplacés par des C 90-40 (SDS 940) avec la particularité de disposer d’un C 90-80 au niveau du dispatching national.

|

|

Les C 90-40 étaient des machines à circuits (faiblement) intégrés et à transistors répartis sur des cartes de petit format, elles-mêmes enfichées sur des fonds de paniers répartis dans plusieurs armoires. La mémoire était une mémoire à tores magnétiques. Les mots étaient de 24 bits, mais l’adressage n’était que sur 14 bits, ce qui donnait une capacité mémoire adressable de 16 Kmots (soit seulement 48 Koctets). La mémoire physique pouvait monter à 32 Kmots, les 16 Kmots supplémentaires pouvaient être utilisés, moyennant une astuce système, pour stocker des données mais ne pouvaient pas contenir d’instructions directement exécutables. (en savoir plus sur les 90-40)

L’architecture retenue

L’architecture retenue est maintenant classique pour les SCADA, à savoir deux calculateurs fonctionnant en permanence, avec reprise automatique des traitements temps réel par la seconde machine en cas de panne de la première. Cependant l’architecture n’était pas symétrique tant du point du vue matériel que logiciel. Une machine était réservée aux traitements temps réel et l’autre aux traitements différés. Ces traitements différés s’exécutaient hors ligne, ce qui signifiait que l’automaticité du secours n’était pas assurée lorsqu’ils étaient en cours. Il était alors nécessaire d’arrêter les traitements et de relancer la machine en mode temps réel. Il est à noter que les dispatchings de Brive et de Marseille ne disposaient au début, que d’une seule machine. Pour ces dispatchings, les traitements hors ligne nécessitaient donc l’arrêt du temps réel. Les dispatcheurs étaient alors amenés à conduire le réseau avec le synoptique, les enregistreurs, le téléphone et bien entendu le schéma de quart. (En savoir plus sur l’architecture).

Le développement

Le développement de ce premier palier fût mené de concert entre le fournisseur retenu (CAE/CII) et EDF. Plus de quarante ans plus tard, la réussite de ce développement nous laisse encore admiratifs. Envisager que l’on puisse faire tenir, OS compris, les fonctionnalités d’un vrai SCADA de base avec moins de 100 Koctets de RAM semble aussi impossible que l’existence de la « fourmi de 18 mètres avec un chapeau sur la tête » de Robert Desnos. La réussite s’est notamment appuyée sur :

-

la mise en œuvre de concepts simples mais efficaces servis par une excellente connaissance des capacités de la machine.

-

l’optimisation au niveau du bit pour les tables système, mais aussi pour les données utilisateur.

-

l’optimisation, pour les instructions déroulées dans le scheduler, faite au niveau du nombre de cycles machine et non du nombre d’instructions. (En savoir plus sur les schedulers).

-

l’optimisation des mouvements des bras de lecture du disque et donc des temps d’accès. La taille et l’emplacement des fichiers, y compris ceux contenant les exécutables des programmes, étaient gérés manuellement, les emplacements étant choisis pour que les mouvements des bras des disques soient minimisés (ainsi, par exemple, les programmes de récurrence minute, étaient positionnés non loin des stockages « minute » puis venaient les programmes de récurrence dix minutes et les fichiers correspondants et ainsi de suite).

-

une répartition judicieuse entre mémoire vive et disque, tant pour les programmes que pour les données.

L’exploit est d’autant plus grand que les tâches de production et de tests des logiciels étaient particulièrement lourdes et sans outillage d’aide (En savoir plus sur les développements du logiciel)

La gestion des données

En l’absence de Système de Gestion de la Base de Données et de Système de Gestion de Fichiers, tout était manuel.

Les cartes perforées constituaient le support initial des données de téléconduite et des données d’imagerie. Un utilitaire permettait de lire ces cartes et de constituer des fichiers qui étaient ensuite versés sur disque.

Comme nous l’avons vu plus haut, la gestion des emplacements des fichiers sur disque était manuelle : un fichier correspondait à une localisation et un nombre défini de secteurs. Lire ou écrire un fichier consistait donc à lire ou écrire un nombre défini de secteurs à un emplacement défini sur le disque (numéro de tête, de cylindre et secteurs).

Ce travail nécessitait une grande méticulosité :

-

La cohérence des données reposait entièrement sur les épaules des opérateurs de saisie,

-

Il en était de même pour la gestion des espaces disque : une erreur sur la taille d’un fichier et on allait écraser le fichier du voisin.

Le déploiement

Le déploiement aura lieu de 1967 à 1971.

A l’issue du développement initial et du déploiement ainsi que d’une formation adaptée, EDF reprendra rapidement la maintenance du logiciel (y compris celle du superviseur) qui sera répartie de façon originale entre les équipes des différents dispatchings (national et régionaux) pour la partie SCADA et Direction des Etudes et Recherches pour la partie modèles)

Les fonctionnalités offertes au dispatcheur

Les fonctionnalités de départ

Chaque dispatcheur disposait d’un poste de travail à 1 ou 2 écrans alphanumériques monochromes et d’un clavier alphanumérique complété par des touches de fonction, le tout lui permettant :

-

D’afficher des schémas de poste simplifiés (représenté à l’aide des caractères disponibles),

-

D’afficher des listes de mesures par poste,

-

De mettre en ou hors surveillance des mesures,

-

De modifier des états de télésignalisations réputés faux (fonction masquage),

-

De consulter la liste des alarmes et des dépassements de seuils.

|

|

Les évolutions

Les C 90-10, limités en termes d’acquisition de mesures, ont rapidement été remplacés par des C 90-40 dans les dispatchings régionaux sauf dans celui de Lille, qui disposait d’un réseau plus petit, et qui a gardé un C 90-10 en parallèle avec un nouveau C 90-40. Le dispatching national bénéficiera en parallèle avec le C 90-40 d’un C 90-80 pour toutes les applications scientifiques.

Compte tenu de leur durée de vie et des évolutions de l’exploitation du système électrique de nombreuses évolutions ont été développées ; nous ne retiendrons ici que quelques unes :

-

Evolution du poste opérateur : Les écrans des dispatcheurs, furent remplacés par des écrans couleur semi-graphiques disposant d’une bibliothèque de symboles graphiques (écrans MP 1000). Ceci permettait d’afficher de véritables images de poste (schémas de poste renseignés avec les mesures de puissance actif/réactif, les mesures de tension et les positions des organes de coupure), et surtout de différencier par la couleur les niveaux de tensions et la gravité des alarmes.

-

Introduction de la télécommande sur le réseau de transport : Le dispatching de Lille qui avait à gérer de nombreux couplages et découplages des groupes des Houillères, tôt le matin et tard le soir a développé la possibilité de télécommander depuis les calculateurs temps réel quelques organes de coupures.

-

Introduction de la télécommande sur des moyens de la production hydraulique : Le dispatching de Toulouse a été amené à développer des automates pour gérer la production de quelques centrales des Pyrénées et notamment le délicat problème des démarrages dans les centrales comportant plusieurs groupes.

-

Introduction de modèles de calcul de réseau : analyse de sécurité dans l’approximation du courant continu :

-

Calcul de répartition. Il a pour objectif le calcul des transits sur les ouvrages à partir des injections aux nœuds électriques. Il a été développé en assembleur à cause des ressources limitées des calculateurs. Il a fonctionné de façon satisfaisante au niveau algorithme. Son fonctionnement effectif en exploitation s’est heurté au fait que trop de positions d’organes de coupure (disjoncteurs, sectionneurs) étaient manuelles et que la moindre erreur (erreur réelle ou décalage dans la mise à jour) de position entrainait des problèmes de convergence ou l’apparition de résultats faux. L’effort de mise à jour en temps réel a longtemps été trop important pour que l’utilisation de ce nouvel outil soit régulière.

-

analyse de sécurité dans l’approximation du courant continu. Il s’agit d’un programme simulant tour à tour un certain nombre de déclenchements pour en évaluer les conséquences sur les transits dans les autres ouvrages. Le modèle utilisé dit dans « l’approximation du courant continu » traite très schématiquement les problèmes de chute de tension qui résultent des déclenchements.

-

Appréciation d’état. Alors que le réseau THT (225 kV et 400 KV) avait un plan de télémesures convenable, les réseaux HT (63 KV et 90 kV) étaient faiblement télémesurés. Pour palier cet état de fait, l’idée est venue de mettre en place un modèle qui donnerait une évaluation de la situation sur ces réseaux faiblement télémesurés. Le principe de base était le suivant : on partait des prévisions de consommations sur les points de livraison et on effectuait un calcul de répartition. Ce calcul donnait des transits sur toutes les liaisons (lignes et transformateurs THT/HT). Là où il existait des mesures (notamment sur les transformateurs THT/HT), on comparait les résultats du calcul avec les mesures et on ventilait les écarts en fonction d’une notion de zone d’influence. Ceci donnait un nouveau point de départ pour les consommations et l’on itérait jusqu’à ce qu’un critère sur l’ensemble des écarts soit atteint.

-

La salle de dispatching de Lyon en 1971. Le synoptique est encore plus imposant que celui de Nancy (CF supra).On remarquera les postes de travail à un seul écran. La salle de dispatching de Lyon en 1971. Le synoptique est encore plus imposant que celui de Nancy (CF supra).On remarquera les postes de travail à un seul écran. |

Compte-tenu de leur durée de vie, les 90-40 ont été amenés à suivre les évolutions de leur environnement informatique, et à s’ouvrir à l’extérieur :

-

Le Système de Gestion Energétique Prévisionnel (SGEP) sera déployé de 1972 à 1975. Il reprendra à son compte une partie des travaux effectués sur la machine de traitement différé. Une passerelle, basée sur un Mitra 15, sera mise en place dans chaque dispatching pour permettre la transmission, du 90-40 vers le SGEP, des réalisations (CPRC et Photos) (6)

-

Des Calculateurs d’Acquisition (les CACQ), jouant le rôle de frontaux pour les 90-40, seront déployés de 1977 à 1981 dans le cadre du SDART (en savoir plus sur le SDART),

-

Le Réglage Secondaire de Tension (7) sera déployé de 1979 à 1984. Les 90-40 seront chargés d’acquérir la valeur du niveau de réglage et de le réémettre vers les centrales hydrauliques.

L’exploitation et la maintenance

La maintenance matérielle

Historiquement assurée par CAE, puis CII, CII-HB et BULL au gré des rachats et fusions, elle a été reprise dans les années 80 par les services télécom des CRTT qui ont dû former des technicien à des technologies, certes passionnantes, mais déjà obsolètes.. On trouvait encore à cette époque deux types de maintenance : la maintenance préventive et la maintenance corrective. Les mauvaises langues, fortes de quelques années d’expérience et qui plus est dotées d’un certain humour, aimaient à dire que la maintenance préventive c’était juste avant que la panne arrive et la corrective juste après.

La maintenance préventive consistait

-

à nettoyer les appareils (lecteurs, bandes, disques, télétypes, perforateur…)

-

à recaler les jeux divers dans tout ce qui était mécanique : lecteur de cartes, dérouleur de bandes, télétype, bras des disques… Dans ce dernier cas il fallait assurer la compatibilité des réglages entre les différentes unités pour pouvoir monter n’importe quel disque sur n’importe quelle unité.

-

à ré-étalonner toutes les valeurs des alimentations et plus particulièrement celles des mémoires à tores.

La maintenance corrective intervenait suite à incident pour trouver la panne et y remédier. Pour ce faire les techniciens disposaient de programmes de tests qui leur permettaient en général de trouver le sous-ensemble en panne. Ensuite c’était le règne de l’oscilloscope à déclenchement. La carte suspectée était mise au bout d’un prolongateur et à l’aide du schéma électronique de la carte, le mainteneur suivait la propagation des signaux en pas à pas. Un fois le composant en panne détecté, il était changé au fer à souder. Si cela peut sembler totalement archaïque au vu des méthodes actuelles, cela était l’occasion d’acquérir des connaissances sur le fonctionnement profond d’un ordinateur, connaissances qui furent utiles à un certain nombre d’entre nous pour les projets ultérieurs. Au fur et à mesure du temps, la récupération de pièces sur des calculateurs en fin de vie a permis d’alléger les tâches de réparations immédiates en jouant sur les stocks de cartes existant.

La maintenance logicielle et l’exploitation

La maintenance logicielle a été rapidement reprise en main par le Service des Mouvements d’Energie. Dans chaque région, une équipe traitement de l’information comportait aux alentours de quatre analystes-programmeurs et deux techniciens. Les techniciens s’occupaient principalement des tâches d’exploitation courantes : mise à jour des données, aide aux tâches de facturation, de statistiques… Les analystes outre le développement des programmes et leur insertion en exploitation, étaient en charge de la maintenance logicielle et intervenaient en et hors des périodes d’heures ouvrables en cas de pannes. Généralement, hors heures ouvrées, les dispatchers effectuaient le redémarrage du système (au moins un des calculateurs) à partir d’une procédure pré-établie et, en cas d’échec, ils faisaient appel aux analystes. Ceux-ci venaient redémarrer le système, éventuellement après une tentative à distance au téléphone (c’était notamment le cas à Paris compte tenu d’un éloignement plus grand des analystes). L’obsolescence du matériel et une exploitation du réseau plus tendue ont conduit certaines régions à mettre en place une astreinte informatique.

Cette organisation un peu atypique a rempli pleinement ses objectifs en permettant une maintenance évolutive proche de l’exploitant des dispatchings et une continuité du service offert grandement satisfaisante le tout en s’appuyant sur des matériels somme toute assez fragiles et fortement contraints en place et en puissance. Par ailleurs, le potentiel acquis tant au niveau informatique que fonctionnel a été un des piliers sur lequel le palier SIRC s’est appuyé pour sa réussite.

notes de bas de page

(1) Pour une centrale en fonctionnement, le coût marginal est le coût de production d’un kw/h supplémentaire.

retour

(2) Le CAE 510 est une adaptation pour le marché civil du RW 530 de la société Ramo-Wooldridge.

retour

(3) Calcul de court-circuit : calcul permettant de calculer la puissance amenée par le réseau lors d’un court-circuit franc et les chutes de tension dans les postes électriques qui en résultent. Une puissance de court circuit élevée permet une meilleure résistance du réseau aux perturbations (déséquilibre, flicker, creux de tension…) mais elle doit rester dans les limites du matériel (jeux de barres des postes, pouvoir de coupure des disjoncteurs…)

retour

(4) Mécanisme contribuant au respect de l’équilibre production-consommation. Il élabore et envoie toutes les 10 secondes aux centrales participant à ce réglage, un ordre de production : le niveau. Ce niveau est élaboré à partir des écarts entre la fréquence de consigne et la fréquence mesurée et les échanges programmés aux frontières et les échanges mesurés. Le niveau variait de -1 (insuffisance de production) à +1 (surproduction.)

retour

(5) Emetteur Récepteur Cyclique composé d’un système de captation/émission dans chaque poste et de récepteurs au dispatching

retour

(6) Courbes a posteriori de Réalisation de Charges : série de 48 moyennes ½ horaires pour des rubriques portant sur les différents types de production, la consommation et les échanges. Les photos sont des situations instantanées du réseau (TM + TS + topologie). Ces données sont ensuite agrégées au niveau France.

retour

(7) Dispositif destiné à maintenir la tension à une valeur de consigne dans des postes appelés points pilote. Des régulateurs situés dans les dispatchings élaborent un ordre de production de réactif (le niveau de RST) qui est ensuite envoyé dans les centrales qui participent à ce réglage.

retour